Vectoren: Afstand, hoek, inproduct en uitproduct

Toepassingen

Toepassingen

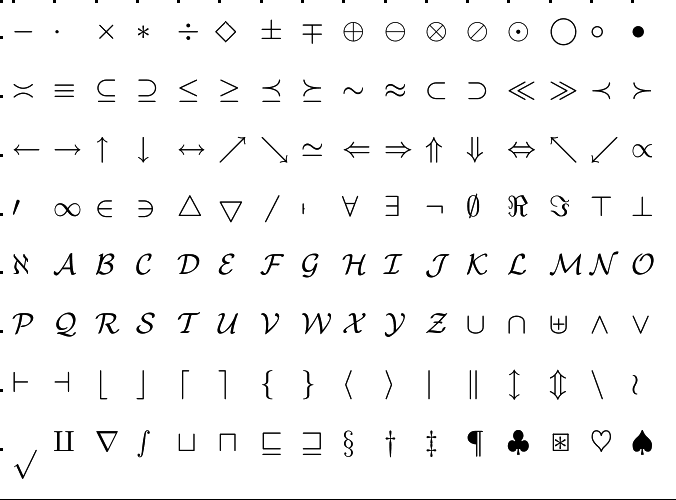

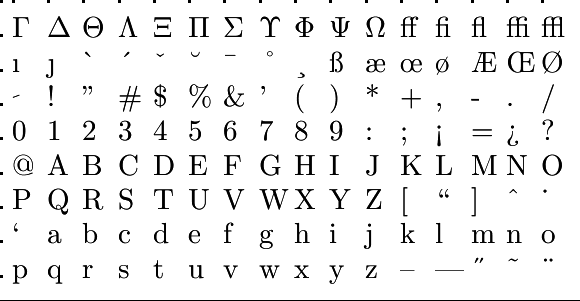

We bespreken een aantal toepassingen van het inproduct en orthogonale projectie in de context van statistiek en neurale signalen. Hierbij is het handig om eerst nog eens naar de notatie van een vector als kolomvector te kijken. Dit was een arbitraire keuze en rijvectoren zullen ook in deze conventie belangrijk zijn. Daarom hebben we een notatie voor transpositie of spiegeling nodig, om van een kolomvector een rijvector te maken en vice versa. We noteren dit met het symbool \(\top\) als superscript

Getransponeerde vector Als \(\vec{x}=\cv{x_1\\x_2\\ \vdots \\ x_n}\) dan is \(\vec{x}^{\top}=(x_1, x_2, \ldots, x_n)\) de getransponeerde vector, en omgekeerd \((\vec{x}^{\top})^{\top}=\vec{x}\).

Deze notatie staat dicht bij het begrip matrix met één kolom of één rij. Als \(\vec{x}=\cv{x_1\\ x_2 \\ \vdots \\ x_n}\) beschouwd wordt als matrix met één kolom, dan is \(\vec{x}^{\top}=(x_1\;\;x_2\;\;\ldots\;\; x_n)\) een matrix met één rij en is het inproduct van de vectoren als een matrixproduct te beschouwen: \[\vec{x}\boldsymbol{\cdot} \vec{y} = \vec{x}^{\top}\!\!\cdot\vec{y}\]

Andere veelgebruikte notaties voor de getransponeerde vector \(\vec{x}^{\top}\) zijn \(\vec{x}^t\) en \(\vec{x}'\).

Gemiddelde, variantie, covariantie, correlatie Stel dat je een serie metingen \((\eta_1, \eta_2,\cdots, \eta_n)\) hebt, dan kun je het als een kolomvector \(\vec{\eta}\) beschrijven via \(\vec{\eta}=(\eta_1, \eta_2,\cdots, \eta_n)^{\top}\). Het gemiddelde \(\mu\) is gedefinieerd als \[\mu=\frac{1}{n}\sum_{i=1}^n \eta_i\] Dit kunnen we ook schrijven als inproduct van \(\vec{\eta}\) met de vector \(\frac{1}{n}\,\vec{1}_n\), waarbij \(\vec{1}_n\) een vector is met alle \(n\) componenten gelijk aan \(1\). Dus: \[\mu=\vec{\eta}\boldsymbol{\cdot} (\frac{1}{n}\,\vec{1}_n)=\frac{1}{n}\,\vec{\eta}\boldsymbol{\cdot} \vec{1}_n\]

De variantie \(s^2\) is dan te schrijven als \[s^2=\frac{1}{n-1}\,\left(\vec{\eta}-\mu\vec{1}_n\right)\boldsymbol{\cdot} \left(\vec{\eta}-\mu\vec{1}_n\right)=\frac{1}{n-1}\,\lVert\vec{\eta}-\mu\vec{1}_n\rVert^2\] In iets lossere notatie schrijven we ook wel \[s^2=\frac{1}{n-1}\,\left(\vec{\eta}-\mu\right)\boldsymbol{\cdot} \left(\vec{\eta}-\mu\right)=\frac{1}{n-1}\,\lVert\vec{\eta}-\mu\rVert^2\] en moet de goede verstaander het getal \(\mu\) in de gegeven formule als een vector zien met elke component gelijk aan dat getal.

De covariantie \(\text{Cov}(\vec{x},\vec{y})\) tussen twee datasets \(\vec{x}\) en \(\vec{y}\) van gelijke lengte \(n\) en met gemiddelden gelijk aan nul is gelijk aan \[\text{Cov}(\vec{x},\vec{y})=\frac{1}{n-1}\vec{x}\boldsymbol{\cdot}\vec{y}\]

De correlatie \(\text{Cor}(\vec{x},\vec{y})\) tussen twee datasets \(\vec{x}\) en \(\vec{y}\) van gelijke lengte \(n\) en met gemiddelden gelijk aan nul is gelijk aan \[\text{Cor}(\vec{x},\vec{y})=\frac{\vec{x}\boldsymbol{\cdot}\vec{y}}{\lVert\vec{x}\rVert\cdot\lVert\vec{y}\rVert}\] De Cauchy-Schwarz ongelijkheid betekent dat de correlatie alleen maar waarden aan kan nemen tussen \(-1\) en \(1\).

Kwadratisch integreerbare reële functies Beschouw de verzameling van reële functies die kwadratisch integreerbaar zijn op een zeker domein, zeg \([-1,1]\), dat wil zeggen, reële functies waarvoor \(\int_{-1}^1f(x)^2\,dx\) bestaat en eindig is. Op deze verzameling van functies kunnen we een inproduct definiëren als \[f\boldsymbol{\cdot}g = \int_{-1}^1 f(x)\cdot g(x)\,dx\]

Fourierreeks Beschouw de verzameling van periodieke reële functies op \([-\pi,\pi]\). Op deze verzameling van functies kunnen we een inproduct definiëren as \[f\boldsymbol{\cdot}g = \frac{1}{\pi}\int_{-\pi}^{\pi} f(t)\cdot g(t)\,dt\] De functies \(1\), \(\cos(t), \cos(2t), \sin(t), \sin(2t), \ldots\) zijn orthogonaal, de goniometrische functies hebben norm 1, en het inproduct \(1\boldsymbol{\cdot}1\) is gelijk aan \(2\), oftewel de constante functie \(1\) heeft norm \(\sqrt{2}\). Een periodieke functie \(f\) kan door loodrechte projectie benaderd worden; bijvoorbeeld: \[t \approx 2\sin(t)-\sin(2t)\]

Sensitiviteit van lichtgevoelige cellen Het spectrum van een lichtbron kan beschreven worden als een vector \(\vec{l}=(l_1, l_2,\cdots, l_n)^{\top}\); denk hierbij aan een lichtbron waarvan de intensiteit van \(n\) vast gekozen lichtfrequenties is bepaald. Net zo kunnen we het absorptiespectrum van een kegelvormige cel van een specifiek type in de retina beschrijven met een vector \(\vec{s}=(s_1, s_2,\cdots, s_n)^{\top}\); bijvoorbeeld, een kegel van type \(S\) met de waarden die een maximum aannemen bij een index \(k\) die correspondeert met een golflengte van \(440\,\text{nm}\). De respons \(R\) van de lichtgevoelige cel op een willekeurige lichtbron \(\vec{l}\) kan dan berekend worden als het inproduct van \(\vec{s}\) en \(\vec{l}\): \[R=\vec{s}\boldsymbol{\cdot}\vec{l}=\vec{s}^{\top}\!\!\cdot \vec{l}=\sum_{i=1}^ns_il_i\]

Regressie Ook regressie volgens de kleinste kwadratenmethode is in vectoralgebra te bevatten. Stel dat je een serie metingen \((\eta_1, \eta_2,\cdots, \eta_n)\) op tijdstippen \((t_1, t_2,\cdots, t_n)\) hebt die je als een kolomvector \(\vec{\eta}\) beschrijft via \(\vec{\eta}=(\eta_1, \eta_2,\cdots, \eta_n)^{\top}\!\!\). Ook de tijdstippen van bemonstering kunnen we ook als een vector beschrijven, zeg \(\vec{t}=(t_1, t_2,\cdots, t_n)^{\top}\!\!\). Bij een lineair regressiemodel \(y=a\cdot t + b\), dat wil zeggen een rechte lijn benadering, zoeken we waarden voor \(a\) en \(b\) zodanig dat \(\lVert a\cdot\vec{t}+ b\cdot\vec{1}_n - \vec{\eta}\rVert^2\) minimaal is. Dit is in feite niets ander dan de orthogonale projectie van \(\vec{\eta}\) op het 2-dimensionale opspansel van de vectoren \(\vec{t}\) en \(\vec{1}_n\) opsporen en deze als lineaire combinatie van \(\vec{t}\) en \(\vec{1}_n\) op te schrijven.

In het nog eenvoudigere model \(y=a\cdot t\) gaat het om de orthogonale projectie van \(\vec{\eta}\) op \(\vec{t}\) en is de gezochte parameterwaarde \(a\) te berekenen als \[a=\frac{\vec{\eta}\boldsymbol{\cdot}\vec{t}}{\vec{t}\boldsymbol{\cdot}\vec{t}}\]